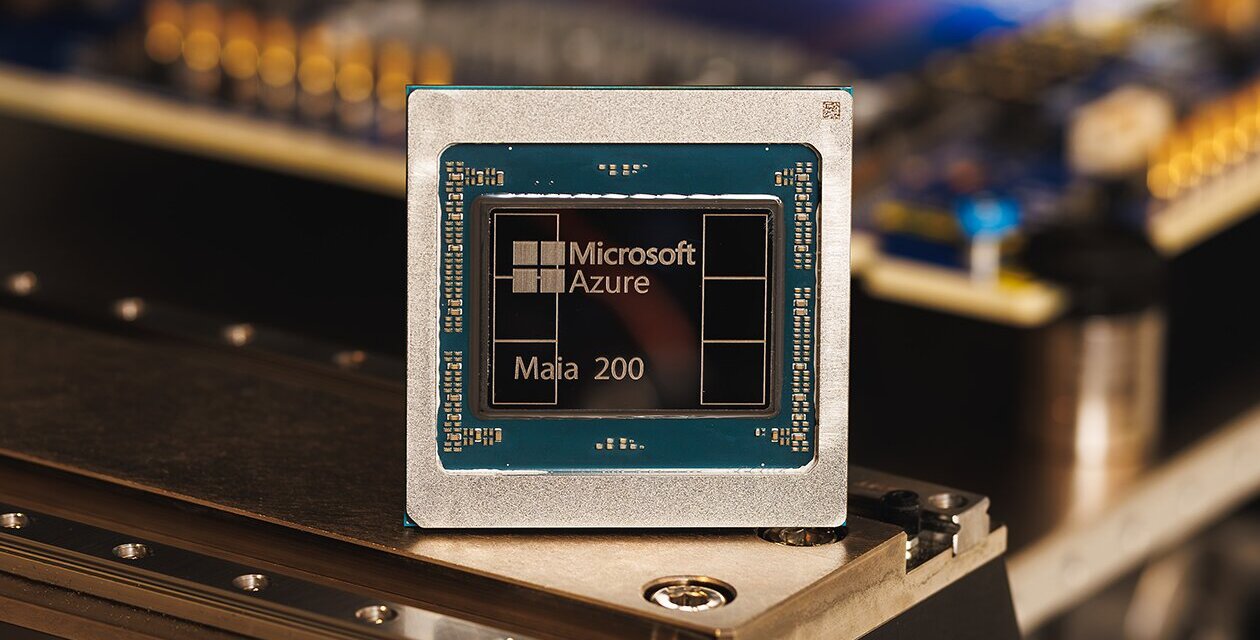

Microsoft anunció el lanzamiento de Maia 200, su acelerador de inteligencia artificial de próxima generación, diseñado específicamente para tareas de inferencia, con el objetivo de ejecutar modelos de IA de forma más rápida y rentable dentro de su nube Azure.

Con esta segunda generación de su chip de inteligencia artificial, busca reducir su dependencia de Nvidia y competir frente a Google y Amazon en el mercado de la computación en la nube.

Según Microsoft, Maia 200 es el acelerador de inferencia más eficiente que ha desplegado hasta ahora, con un 30% más de rendimiento por dólar frente al hardware de última generación actualmente utilizado en su flota. Además, la empresa afirma que supera en rendimiento FP4 al Trainium de tercera generación de Amazon y en FP8 al TPU de séptima generación de Google.

El nuevo acelerador forma parte de la infraestructura heterogénea de IA de Microsoft y será utilizado para ejecutar múltiples modelos, incluidos los más recientes GPT-5.2 de OpenAI, así como para potenciar servicios como Microsoft Foundry y Microsoft 365 Copilot. Asimismo, el equipo de Microsoft Superintelligence empleará Maia 200 en la generación de datos sintéticos y procesos de aprendizaje por refuerzo para mejorar sus modelos internos.

El chip ya se encuentra desplegado en la región US Central de Azure, cerca de Des Moines (Iowa), y próximamente llegará a US West 3, en las cercanías de Phoenix (Arizona), con planes de expansión a otras regiones en el futuro.

Diseñado para tareas de inferencia, Maia 200 fue fabricado con tecnología de 3 nanómetros de TSMC y ofrece mejoras significativas en rendimiento y eficiencia de costos para ejecutar modelos de IA en Azure.

Con Maia 200, Microsoft refuerza su apuesta por el desarrollo propio de silicio y busca establecer nuevos estándares en eficiencia, rendimiento y escalabilidad para la próxima etapa de la inteligencia artificial a gran escala en la nube.